Folgende vier entscheidende Schlüsselfaktoren müssen berücksichtigt werden, wenn es um die Wahl und Implementierung einer SAN-basierenden Speicher-Infrastruktur geht:

1. Wie stark muss die Infrastruktur skalieren können, und kann sie dies, ohne dass die Speicherumgebungen unterbrochen werden müssen?

2. Wie hoch verfügbar muss die Infrastruktur sein? Wird künftiges Wachstum die Verfügbarkeit beeinträchtigen?

3. Unterstützt der Sicherheitslevel die heutigen und künftigen Anforderungen?

Skalierbarkeit: «Pay as you grow»

Die Fiber-Channel basierenden SANs haben grundsätzlich zwei Vorgehensweisen, um ein Framework von Speicheranwendungen zu bauen: zentralisiert und vernetzt.

Das zentralisierte Modell basiert normalerweise auf einem monolithischen Interkonnektionsgerät, genannt Director, welches eine grössere Anzahl Ports hat und darum meist auch die grösseren Anfangsinvestitionen verlangt.

Wenn in einem zentralisierten SAN die Kern-Interkonnektion einmal installiert ist, so kann das SAN durch die Interkonnektion von kleineren switched-fabric SANs, in Abteilungen und Arbeitsgruppen erweitert werden, welche später an den grossen Switch angeschlossen werden und so eine unternehmensweite SAN-Architektur anbieten. Ein häufiges Argument gegen eine zentralisierte Lösung ist somit die oft hohe Investion in Directors, die es zu Beginn zu tätigen gilt.

Eine Alternative dazu ist das vernetzte Vorgehen zu einer SAN-Infrastruktur.

Im vernetzten SAN-Modell werden die Interkonnektionsgeräte kaskadiert oder miteinander verbunden, so dass ein maschenartiges Gewebe entsteht. Ein Vorteil des vernetzten Ansatzes ist der kostengünstige Einstieg in ein SAN, welches auch auf die grösstmögliche Anzahl Ports skalieren kann, und das in einer «pay as you grow»-Manier.

Viele SANs werden zuerst in einer Arbeitsgruppe oder einer Abteilung eingesetzt und expandieren dann im Lauf der Zeit bis hin ins Data Center. So kann z.B. ein Anwender mit einem vernetzten Ansatz zwei kleinere Switches für die Unix-Speicherkonsolidierung in einer Abteilung benutzen und dann zwei weitere Switches hinzufügen, um die NT-Konsolidierung in einer anderen Abteilung voranzutreiben.

Wenn der Anwender soweit ist, dass er das Backup sowohl für die Unix als auch die NT-Umgebung über ein LAN-freies Backup (unter Benützung teurer Backup-Geräte an einem anderen Ort) zentralisieren kann, fügt er weitere Switches zum Geflecht hinzu, um diese Backup-Lösung zu ermöglichen.

Verteilte Intelligenz

Zusätzliche Anforderungen an eine SAN-Struktur treten meist in verschiedenen Gebieten, zu unterschiedlichen Zeiten und mit spezifischen technologischen Anforderungen auf. Ein Anwender muss z.B. ein SAN vergrössern, um zusätzliche Server und Speichersysteme oder neue Applikationen unterstützen zu können. Oder ein SAN muss wachsen, um mit neuen Technologien oder höheren Geschwindigkeiten mithalten zu können.

Deshalb ist es wichtig, dass die Umgebung ohne Beeinflussung der Speicherumgebung skalieren kann. Im obigen Beispiel gibt es durch das Hinzufügen von Switches zu einem bestehenden Geflecht weder Unterbrüche für die Server noch für die Speicherumgebung – und auch das Geflecht skaliert ohne Redesign.

Dieser Grad an Flexibilität und Skalierbarkeit ist nur erreichbar, wenn die Switching-Infrastruktur über verteilte Intelligenz verfügt, neue Switches im Geflecht automatisch erkennt und gewisse Informationen über das gesamte Geflecht verteilt, wie z.B. die Adressierung und Zoning-Information.

Das vernetzte Modell hat ebenfalls Vorteile bei Technologiewechseln. So können z.B. beim Wechsel von 1 Gb/s zu 2Gb/s Fibre Channel Geschwindigkeit die Anwender eines vernetzten Modells ihre Geräte upgraden, ohne bei jedem Wachstumsschritt den zentralen Switch ersetzen zu müssen.

Ausserdem kann mit dem vernetzten Ansatz das Limit von 10 Kilometern bei

Fiber-Channel-Verbindungen übersprungen werden. Wegen der verteilten Plazierung der Switches können Host und Disksubsystem 20, 30, oder gar 40 Kilometer auseinander stehen.

Wachsen ohne Unterbruch

Hohe Verfügbarkeit bedeutet, dass die Applikation fortwährenden Zugriff auf die Daten hat. Ein hoch verfügbares SAN zu entwickeln heisst, Flexibilität in das darunter liegende Speichernetzwerk zu bringen, so dass bei einem fehlerhaften GBIC, einem Link oder einem ganzen Interkonnektionsgerät, die Applikation ohne Unterbruch Zugriff auf die Daten hat.

Es gibt verschiedenste Fehler, die den Zugriff einer Applikation auf ihre Daten beeinträchtigen können: Hardware-Fehler, Software-Fehler, physische Ursachen wie Feuer, Wasser oder Erdbeben und zu guter Letzt die häufigste Ursache: der Benutzerfehler. Ein SAN-Design beugt vor und minimiert die Möglichkeiten von menschlichen Fehlern. Bei der Wahl von SAN-Infrastrukturen muss der Grad der Automatisierung in Betracht gezogen werden. Wird ein neuer Switch

hinzugefügt, so wird das SAN diesen automatisch erkennen und mit den Informationen über den Rest des Geflechts versorgen.

Diese Art von Selbsterkennung und Selbstkonfiguration ist nur möglich, wenn das Geflecht eine verteilte Intelligenz über das SAN besitzt, und jedes Gerät die nötigen Informationen über die Topologie selbst und unterbruchsfrei lernen kann.

Darüber hinaus sollten Anwender die Flexibilität der darunter liegenden SAN-Infrastruktur berücksichtigen. Kann sich das SAN im Falle eines Port- oder Switch-Fehlers selbst kurieren? Kann es Informationen automatisch um die Fehlerzonen routen? Sind wichtige Komponenten redundant und «hot-swappable”?

Hohe Verfügbarkeit verlangen die Duplikation von Servern, Applikationen, Benutzerzugriffen zu Applikationen, Speichern und vieles mehr. Single Points of Failure können nur durch den mehrfachen Einsatz von Hardware, Software, und Personal vermieden werden! Wenn man sich zwischen einer zentralisierten und einer vernetzten Lösung entscheiden muss, sollte man sich noch einmal die Bedeutung des Single Point of Failure einer Single-Switch Lösung vor Augen halten. Was passiert, wenn im Data Center Feuer ausbricht?

Mehr Sicherheit mit Zoning

Ein fundamentales Sicherheitsfeature eines SANs ist das Zoning. Zoning ermöglicht es, ein SAN mit einersichtbaren «Firewall« logisch zu segmentieren und so den Zugriff und die Sichtbarkeit von Servern und Speichersystemen zu kontrollieren. Netzwerk-Administratoren können dank Zoning ans Netz angeschlossene Geräte, Server, oder Workstations in einem virtuallen SAN, innerhalb der physischen Konfiguration eines SAN-Geflechts, zusammenfassen. Zonenmitglieder sehen nur Mitglieder in ihren Zonen, und können auch nur auf diese zugreifen.

Es gibt zwei verschiedene Arten von Zoning: Hardware-Zoning und Software-Zoning. Um eine optimale Sicherheit zu garantieren, sollte ein Anbieter nicht nur beide Features, sondern auch «Zone overlapping» anbieten, welches einem Speichersystem (oder Server) ermöglicht, in mehr als einer Zone zu sitzen und mit verschiedenen Servern geteilt zu werden, welche vielleicht selbst in verschiedenen Zonen stehen.

Ein weiterer, wichtiger Zoning-Faktor ist seine Skalierbarkeit – wie viele Zonen werden von einem Anbieter unterstützt? Jede Limitierung in der Anzahl von Zonen kann zu Problemen führen, sobald das SAN wächst.

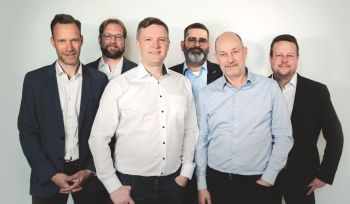

Der Autor

Derek Granath (BILD) ist Director Product Marketing bei

Brocade Communications.